GETTY IMAGES

GETTY IMAGES

De Stephen Hawking a Elon Musk, algumas das principais mentes do mundo levantaram preocupações de que a inteligência artificial represente uma ameaça aos seres humanos.

Mas, de acordo com um novo livro sobre o tema, não devemos temer a possibilidade de uma revolta de robôs autoconscientes contra seus "mestres" humanos.

E sim com o fato de as máquinas se tornarem tão boas em alcançar os objetivos que estabelecemos para elas que podemos acabar aniquilados por ordenarmos, sem perceber, as tarefas erradas.

- A nova função da Netflix que revolta cineastas

- Como se proteger de bug do WhatsApp que pode deixar celular Android vulnerável a hackers

O professor Stuart Russell, da Universidade da Califórnia, é autor de Compatibilidade Humana: Inteligência Artificial e o Problema de Controle (sem versão no Brasil) e especialista nos avanços possibilitados pelo aprendizado das máquinas.

"O mote dos filmes de Hollywood é sempre que a máquina espontaneamente se torna consciente. Depois, decide que odeia seres humanos e quer matar a todos nós", disse ele à BBC.

GETTY IMAGES

GETTY IMAGES

Segundo eles, os robôs não terão sentimentos humanos, então, "esse é um motivo errado para se preocupar".

"Não há realmente (nas máquinas) uma consciência ruim. Há sim uma competência com a qual temos de nos preocupar, a competência para atingir um objetivo que nós especificamos mal".

Ou seja, segundo ele, digamos que uma máquina com inteligência artificial tenha de cumprir uma tarefa que damos a ela. Porém, atingir essa meta pode necessitar tomada de decisões extremas.

Então, provavelmente a máquina não terá condições de fazer um julgamento moral sobre suas ações: vai apenas tentar atingir o objetivo final, como se fosse qualquer outro.

GETTY IMAGES

GETTY IMAGES'Muito competente'

Em uma entrevista ao programa de rádio Today, da BBC, Russell deu um exemplo hipotético da ameaça real que ele acha que a inteligência artificial poderia representar.

Imagine que tenhamos um poderoso sistema de inteligência artificial capaz de controlar o clima do planeta. Nós queremos usá-lo para diminuir os níveis de dióxido de carbono em nossa atmosfera a taxas pré-industriais.

"O sistema então descobre que a maneira mais fácil de fazer isso é se livrar de todos os seres humanos, porque são eles que estão produzindo todo esse dióxido de carbono. Você pode pensar: bom, faça o que você quiser, mas não se livre dos seres humanos. O que a máquina vai fazer?", diz Russell.

Esse exemplo extremo, segundo o professor, serve para destacar os riscos associados à inteligência artificial que age sob instruções que os seres humanos ainda não pensaram.

GETTY IMAGES

GETTY IMAGESSuperinteligência

A maioria dos sistemas atuais de inteligência artificial são "restritos", projetados especificamente para resolver um problema bem específico em uma área, de acordo com o Centro de Estudos de Riscos Existenciais, da Universidade de Cambridge, no Reino Unido.

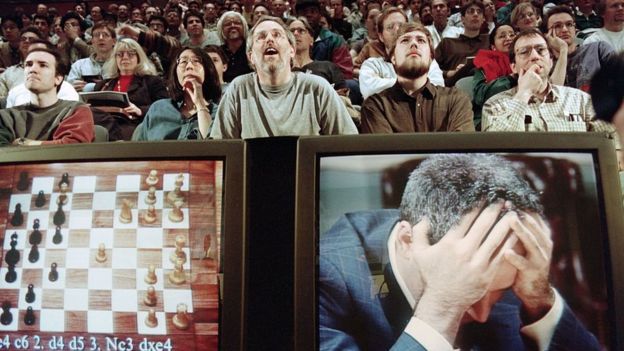

Um momento marcante nesse campo aconteceu em 1997, quando o computador Deep Blue derrotou o então campeão mundial de xadrez, Garry Kasparov, em uma disputa de seis jogos.

Mas, apesar do feito, o Deep Blue foi projetado especificamente por humanos para jogar xadrez e ficaria perdido em um simples jogo de damas.

Os avanços posteriores na inteligência artificial, porém, são diferentes. O software AlphaGo Zero, por exemplo, alcançou um nível excepcional de desempenho depois de apenas três dias jogando Go contra ele mesmo.

Usando o aprendizado profundo, um método de aprendizado de máquinas que usa redes neurais artificiais, o AlphaGo Zero exigia muito menos programação humana. O dispositivo acabou se tornando um excelente jogador de Go, de xadrez e de Shogi.

O mais alarmante, talvez, foi que o computador agiu de forma totalmente autodidata.

"À medida que um sistema de inteligência artificial se torna mais poderoso e mais geral, ele pode se tornar superinteligente, algo superior ao desempenho humano em muitos ou quase todos os domínios", diz o centro de pesquisas britânico.

E é por isso que, segundo o professor Russell, os humanos precisam retomar o controle.

GETTY IMAGES

GETTY IMAGES'Não sabemos o que queremos'

Russell argumenta que dar à inteligência artificial objetivos mais definidos não é a solução para esse dilema, porque os próprios humanos não têm certeza de quais são esses objetivos.

"Não sabemos que não gostamos de uma coisa até que ela aconteça", diz ele.

"Devemos mudar toda a base sobre a qual construímos sistemas de inteligência artificial", diz ele, afastando-se da noção de dar aos robôs objetivos fixos para eles concluírem. "Em vez disso, o sistema precisa entender que não sabe qual é o objetivo final da tarefa", explica.

"E quando você tem sistemas que funcionam dessa maneira, eles realmente se valem dos seres humanos. Eles começarão a pedir permissão antes de fazer as coisas, porque não têm certeza sobre o que a pessoa deseja."

Fundamentalmente, diz o professor Russell, os computadores ficariam "felizes em se deixarem desligar porque querem evitar fazer coisas de que seu controlador não gosta".

O 'gênio da lâmpada'

"A maneira como construímos a inteligência artificial é um pouco como enxergamos um gênio da lâmpada. Você esfrega a lâmpada, o gênio sai e você diz: 'Gostaria que isso acontecesse'", diz Russell.

E se o sistema de inteligência for suficientemente poderoso, ele fará exatamente o que você solicitar.

"Agora, o problema com os gênios nas lâmpadas é que o terceiro desejo (nesse caso) é sempre: 'Desfaça os dois primeiros desejos, porque não conseguimos especificar os objetivos corretamente'."

"Portanto, uma máquina que busca um objetivo que não é o correto se torna, na verdade, um inimigo da raça humana, um inimigo que é muito mais poderoso que nós mesmos", diz Russell.

Da BBC

Professor Edgar Bom Jardim - PE

.jpeg)

0 >-->Escreva seu comentários >-->:

Postar um comentário

Amigos (as) poste seus comentarios no Blog